Qu’est-ce qu’une photo composite ?

Pour faire simple, une photo composite est composée de plusieurs clichés. Un exemple très simple : quand vous faites une photo panoramique avec votre smartphone, vous faites une photo composite, car votre smartphone va en prendre plusieurs et les assembler en une seule pour créer un panorama.

Les différents types de photos composites

Assemblage de photos afin de créer une vue panoramique

Comme expliqué plus haut, l’utilisation la plus répandue consiste simplement à prendre plusieurs photos et d’en créer une plus grande. Selon la manière dont ont été prises les photos et le rendu souhaité, il peut être nécessaire de déformer les photos. Je vous propose ci-dessous d’examiner quelques exemples de photos composites “classiques”.

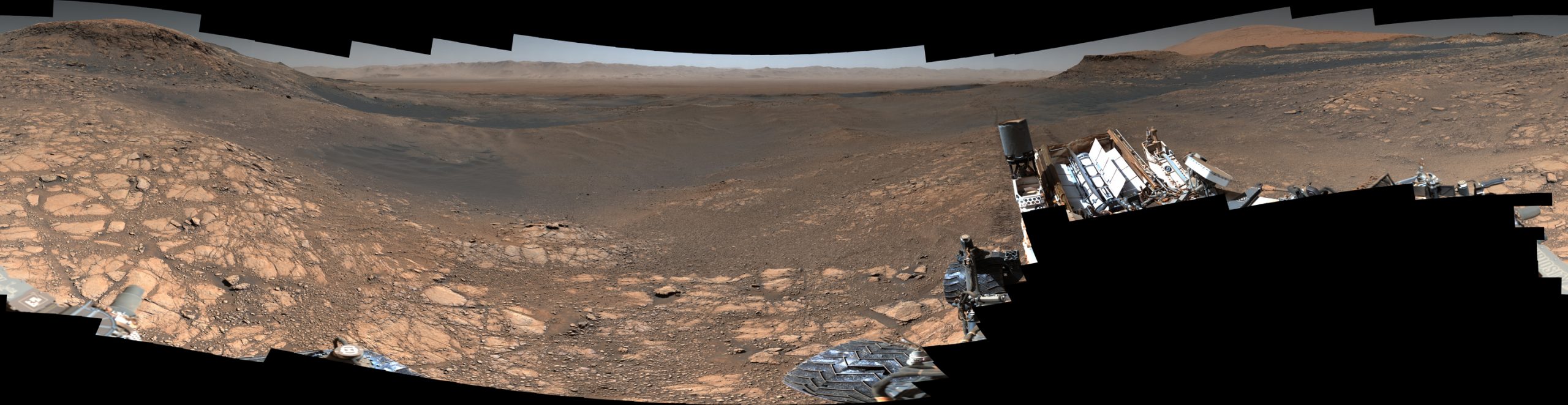

Panorama de la planète Mars par le rover Curiosity 1

Voici un panorama de Mars constitué de plus de 1000 photos prises entre le 24 novembre et le 1er décembre 2019.

Crédits : NASA / JPL-Caltech / MSSS

En laissant visibles les contours noirs, on observe clairement l’assemblage de photos et la déformation appliquée pour que la photo finale soit conforme à la réalité.

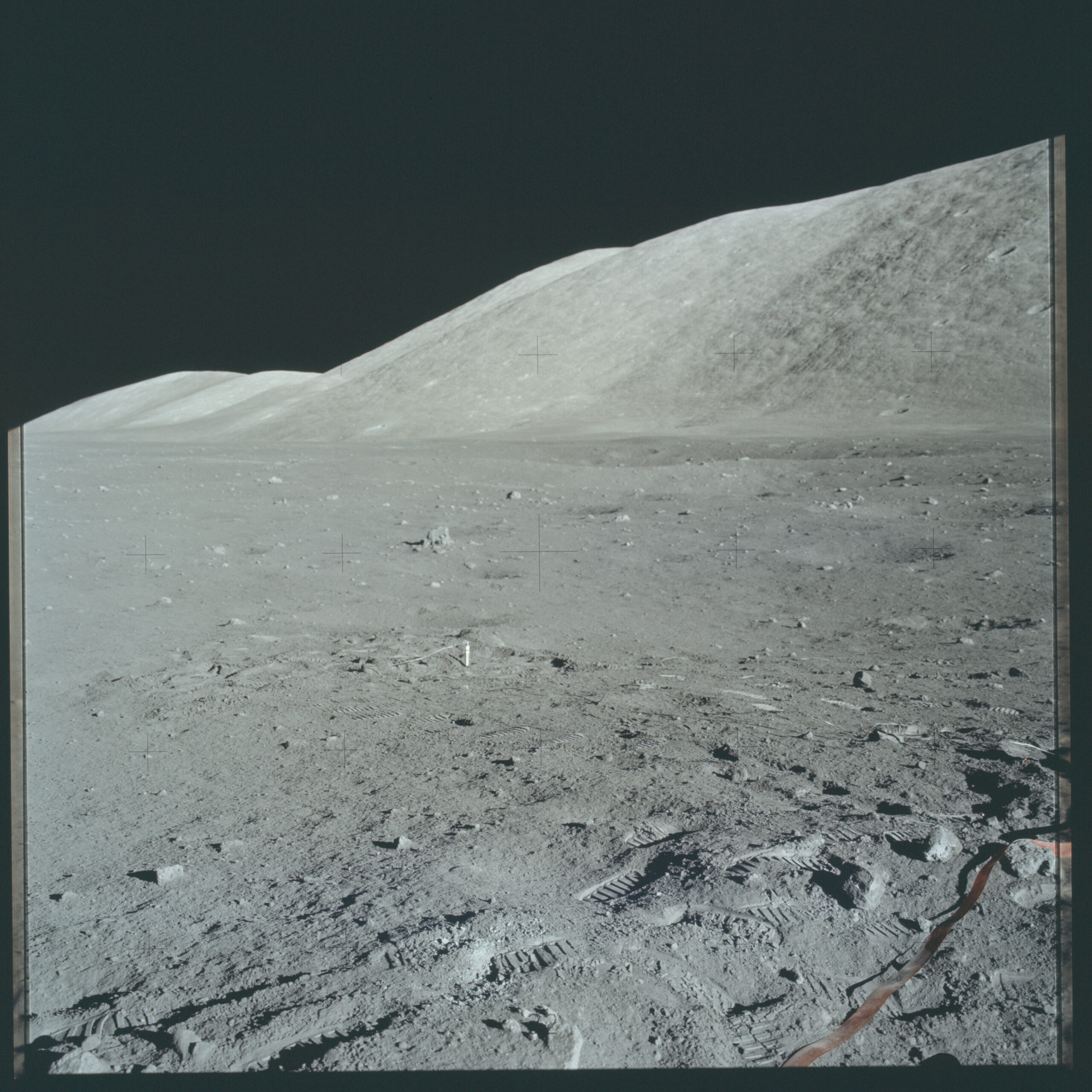

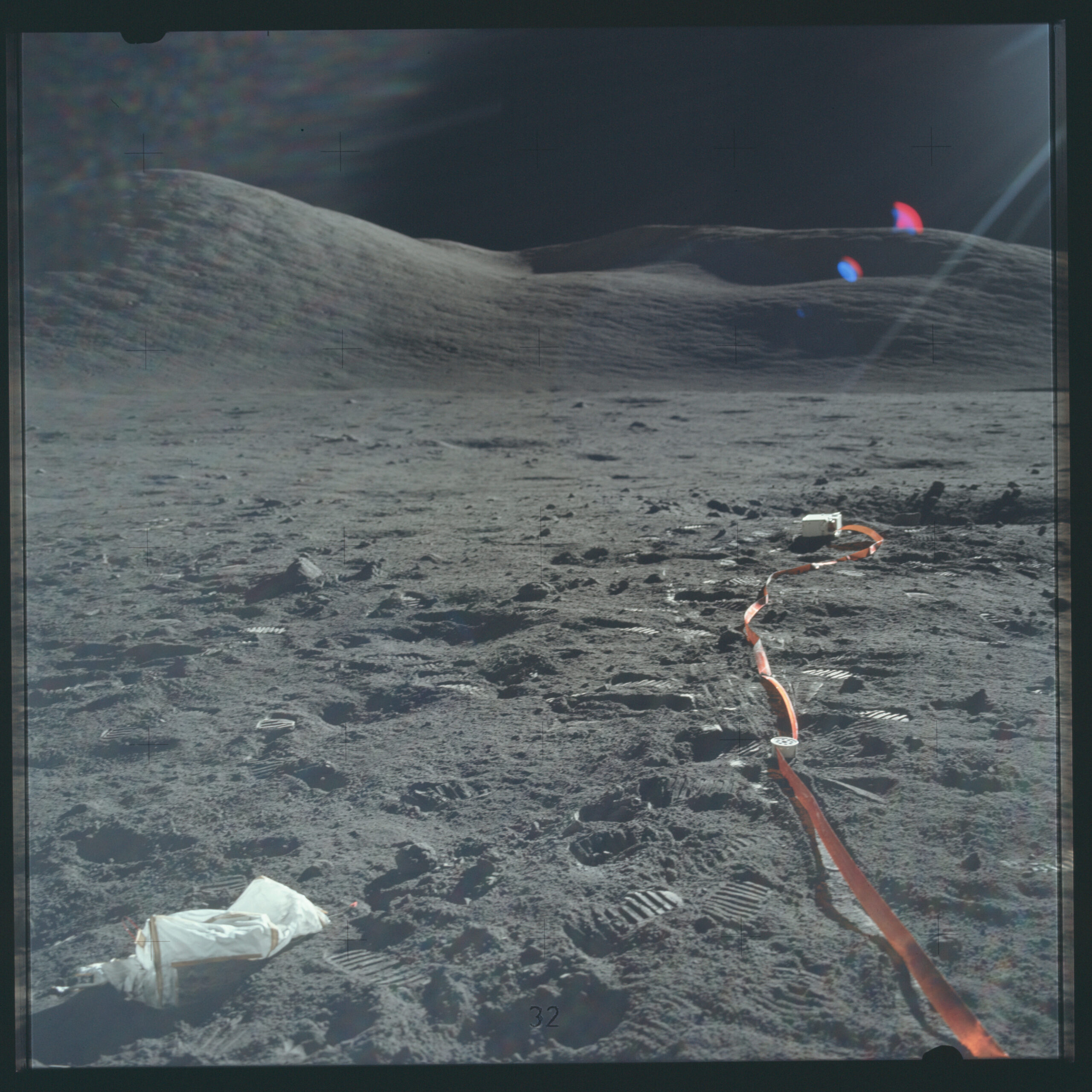

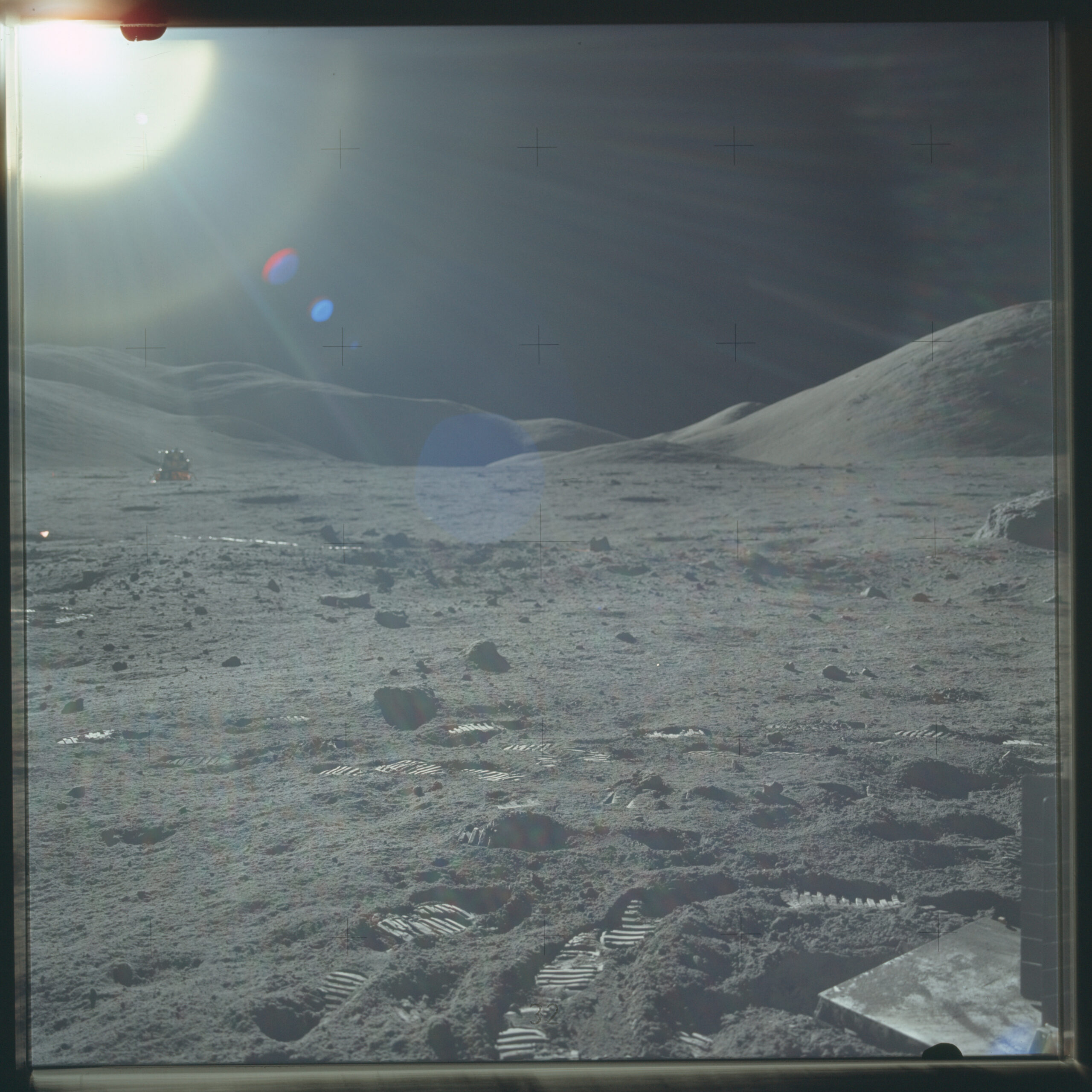

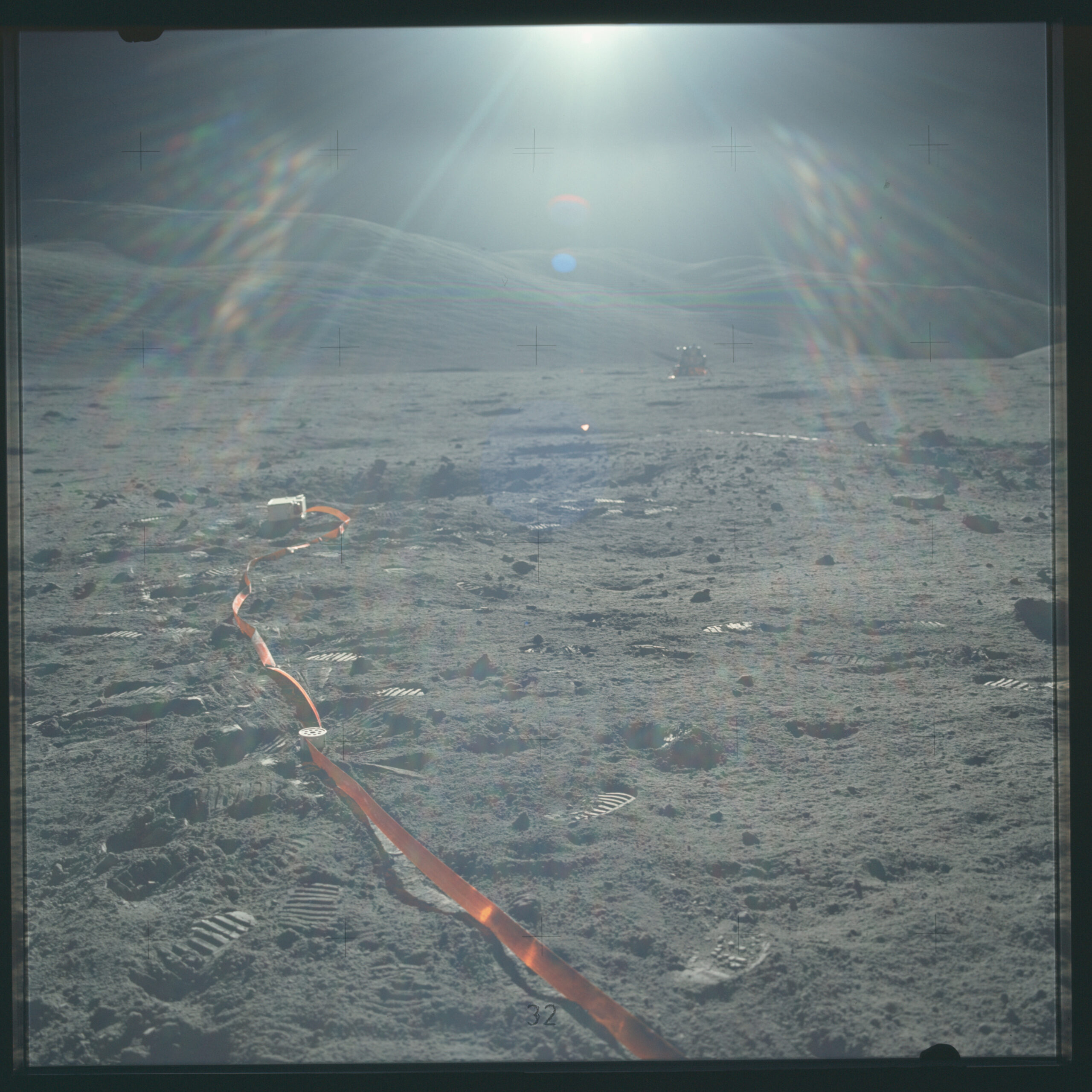

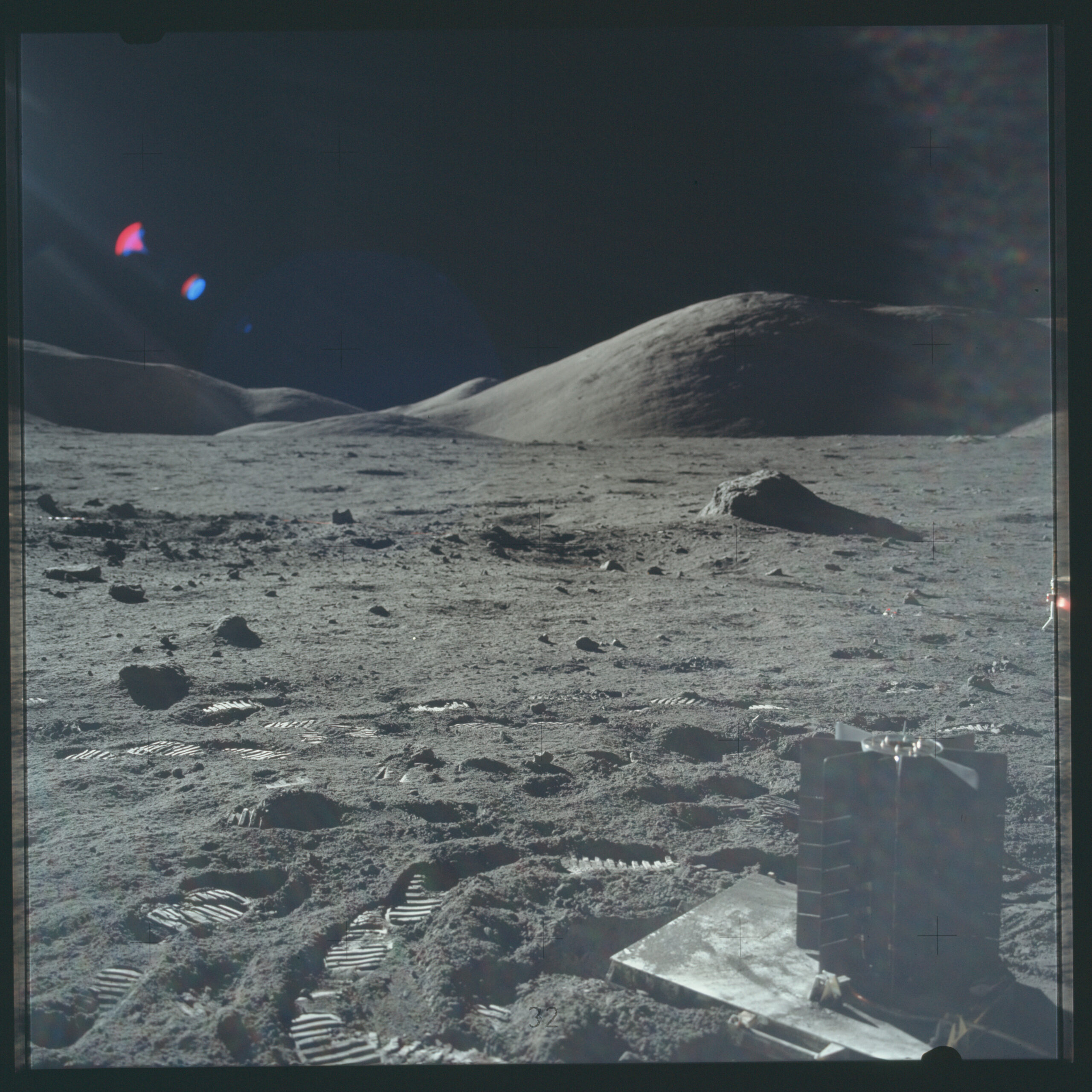

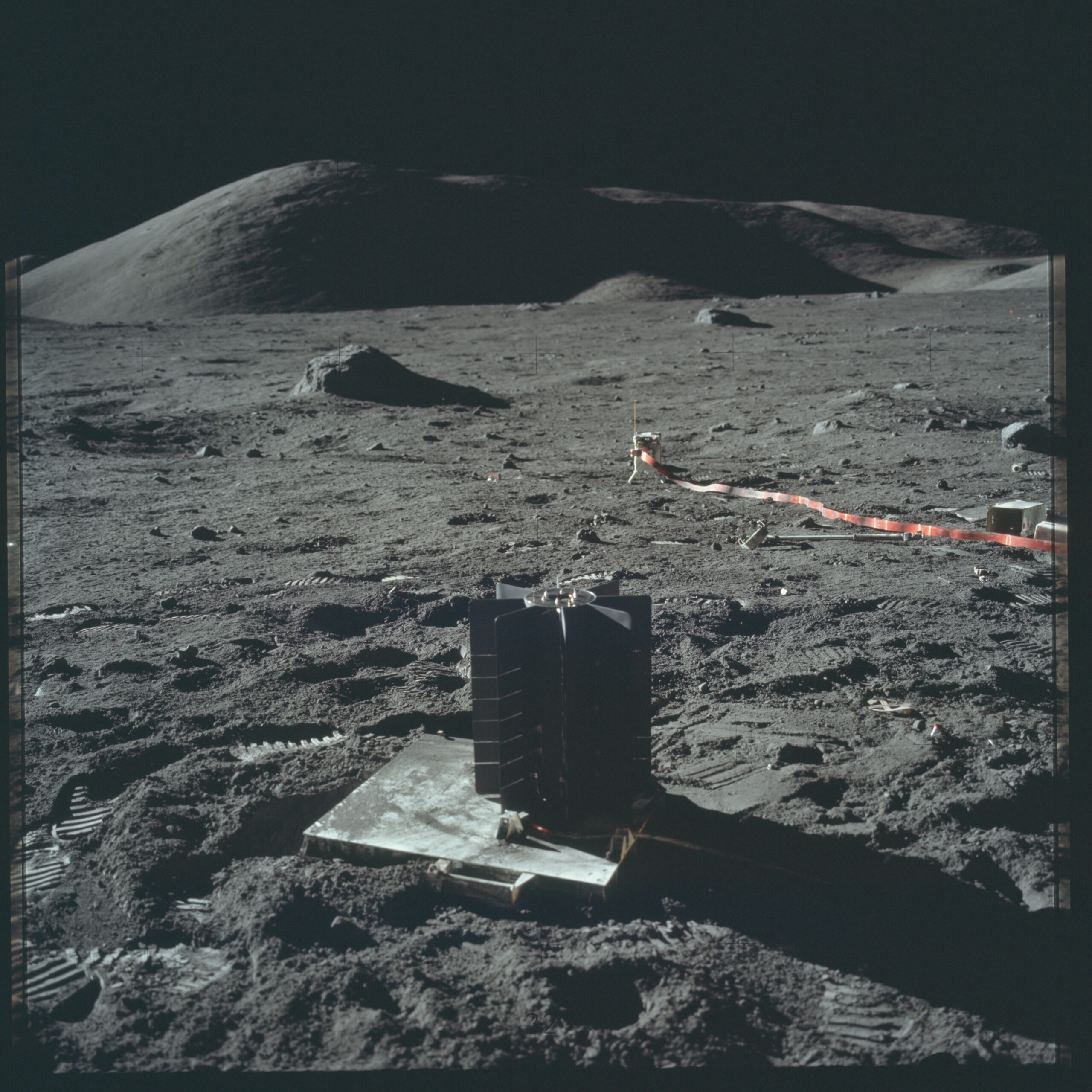

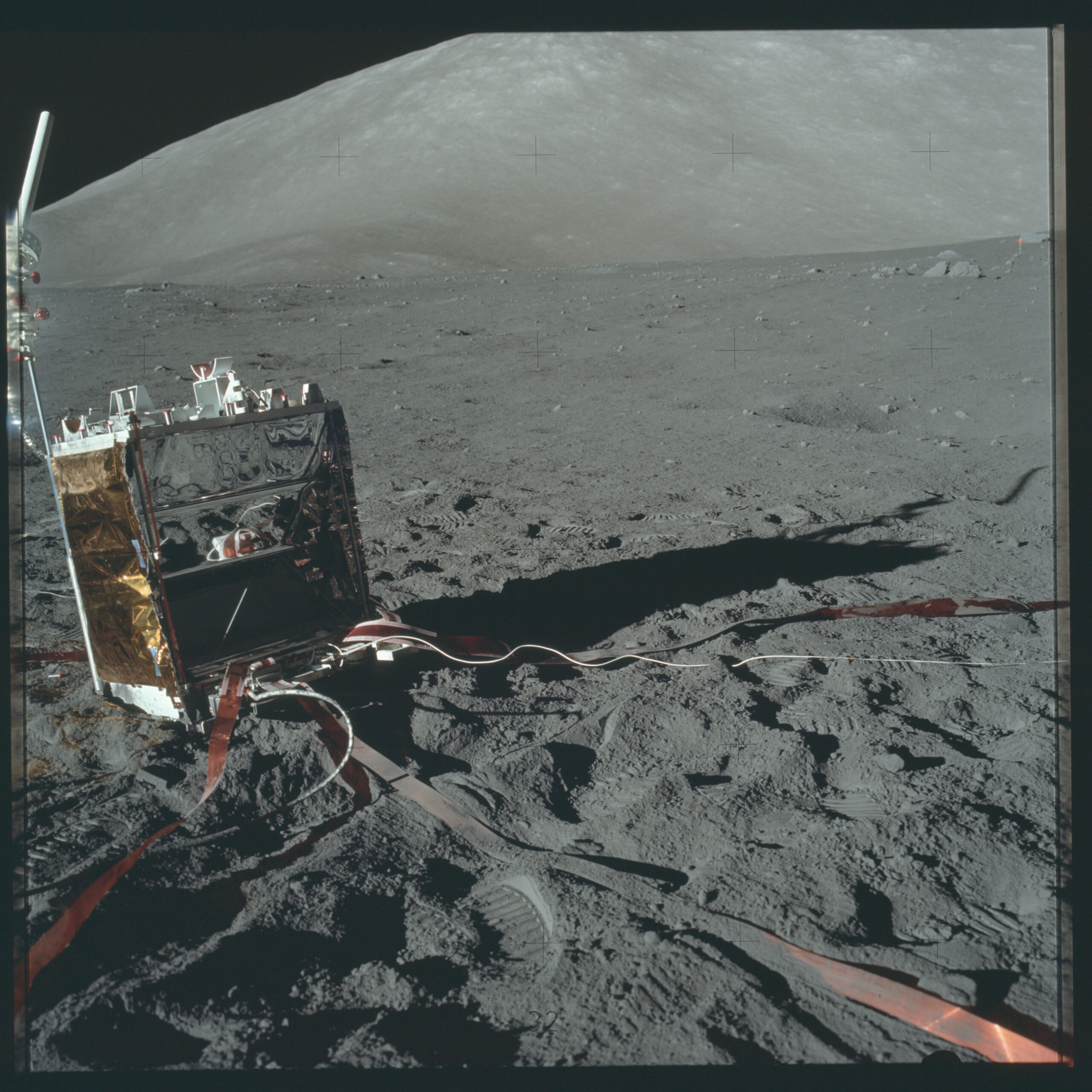

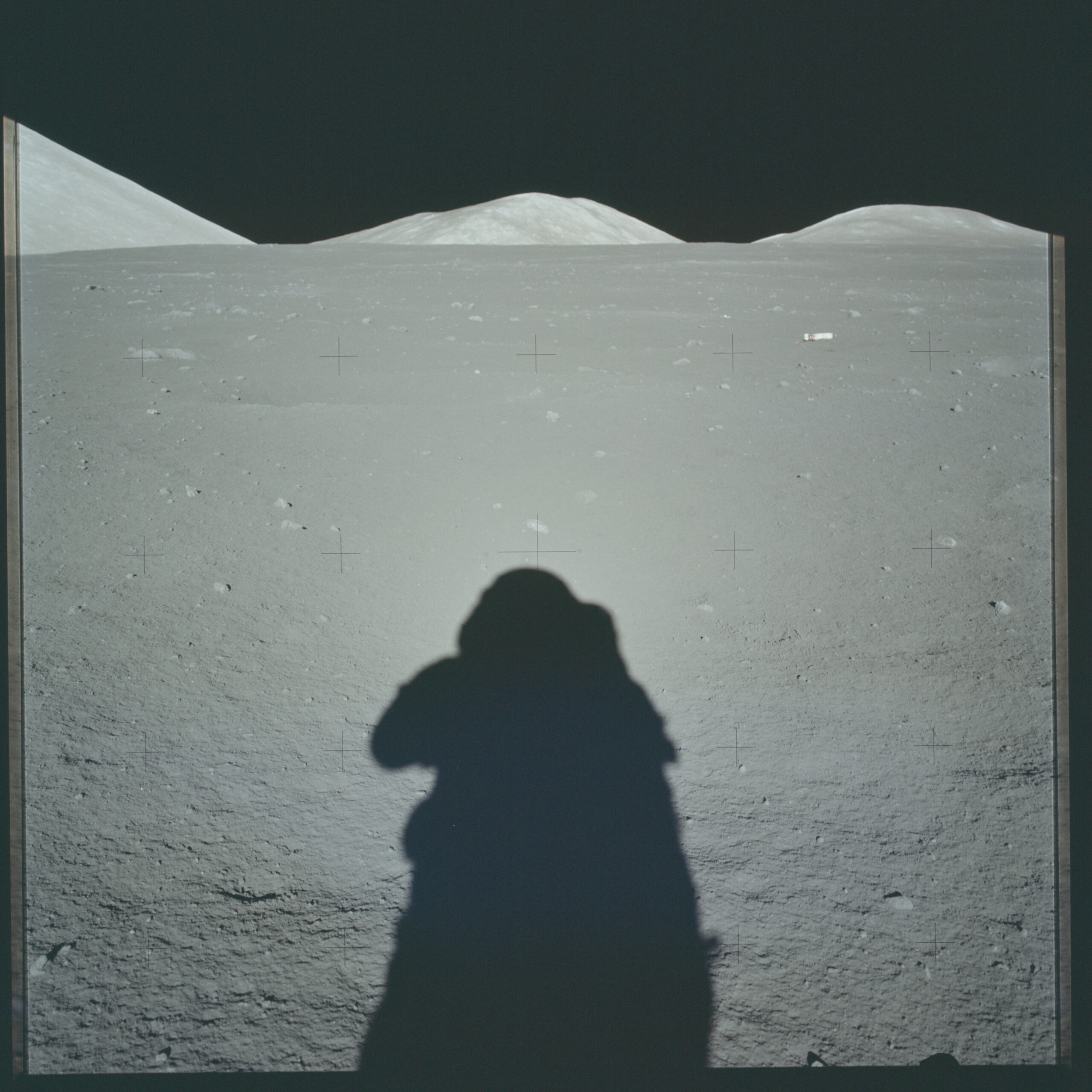

Panorama de la Lune par les missions Apollo 2

Voici un panorama de la Lune assemblé à l’aide des photos prises par la mission Apollo 17.

Crédit : NASA

Ce panorama a été assemblé à l’aide de 19 photos que j’ai rassemblées dans la galerie ci-dessous afin de se rendre compte que construire une telle photo composite ne consiste pas simplement à positionner des photos les unes à côté des autres. Il est nécessaire de déformer et de superposer les photos afin que le rendu soit parfait. En effet, comme vous pouvez le constater, des éléments sont présents sur plusieurs photos comme le ALSEP (Apollo Lunar Surface Experiments Package 3) visible sur les photos AS17-147-22585, AS17-147-22586 et AS17-147-22587 ou encore le générateur thermoélectrique à radioisotope 4 visible sur les photos AS17-147-22582 et AS17-147-22583.

Crédit : NASA

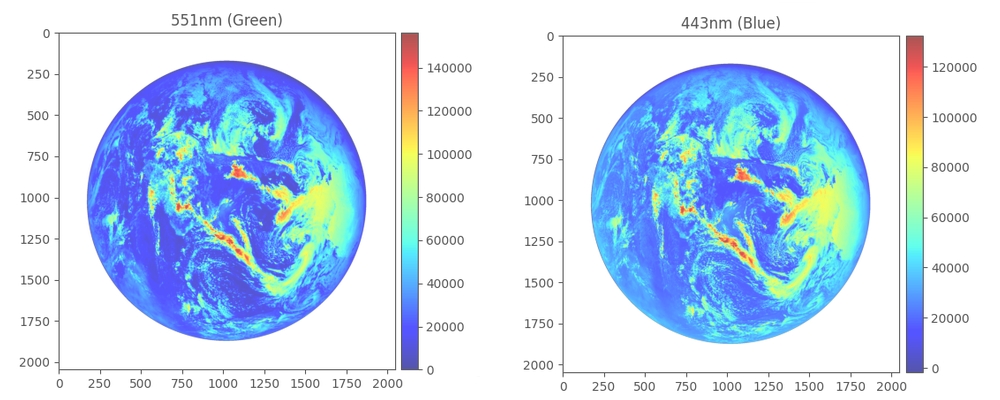

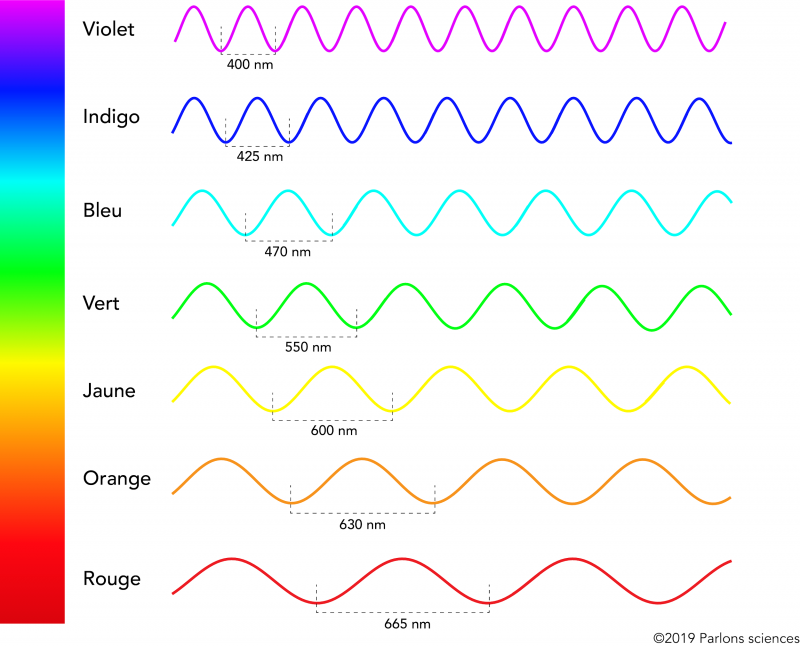

Superposition de plusieurs photos de différentes longueurs d’onde

Dans le but d’avoir des données scientifiques précise et complètes, les satellites prennent des photos dans différentes longueurs d’onde ou bandes spectrales.

Une longueur d’onde définit une couleur très précise et son unité de mesure est le nanomètre (nm), cela représente la distance entre deux crêtes (ou deux creux) consécutives d’une onde lumineuse. Lorsqu’on note une bande spectrale, on l’écrit généralement sous la forme 317.5 ± 0.1. Ce qui signifie qu’on regarde la couleur ayant la longueur d’onde 317,5nm avec une marge de plus ou moins 0,1nm (ce qui est totalement indiscernable à l’œil nu.)

Une bande spectrale est un “groupe” de longueurs d’onde, au lieu d’observer une couleur bien précise, on va observer toutes celles qui sont plus ou moins proches.

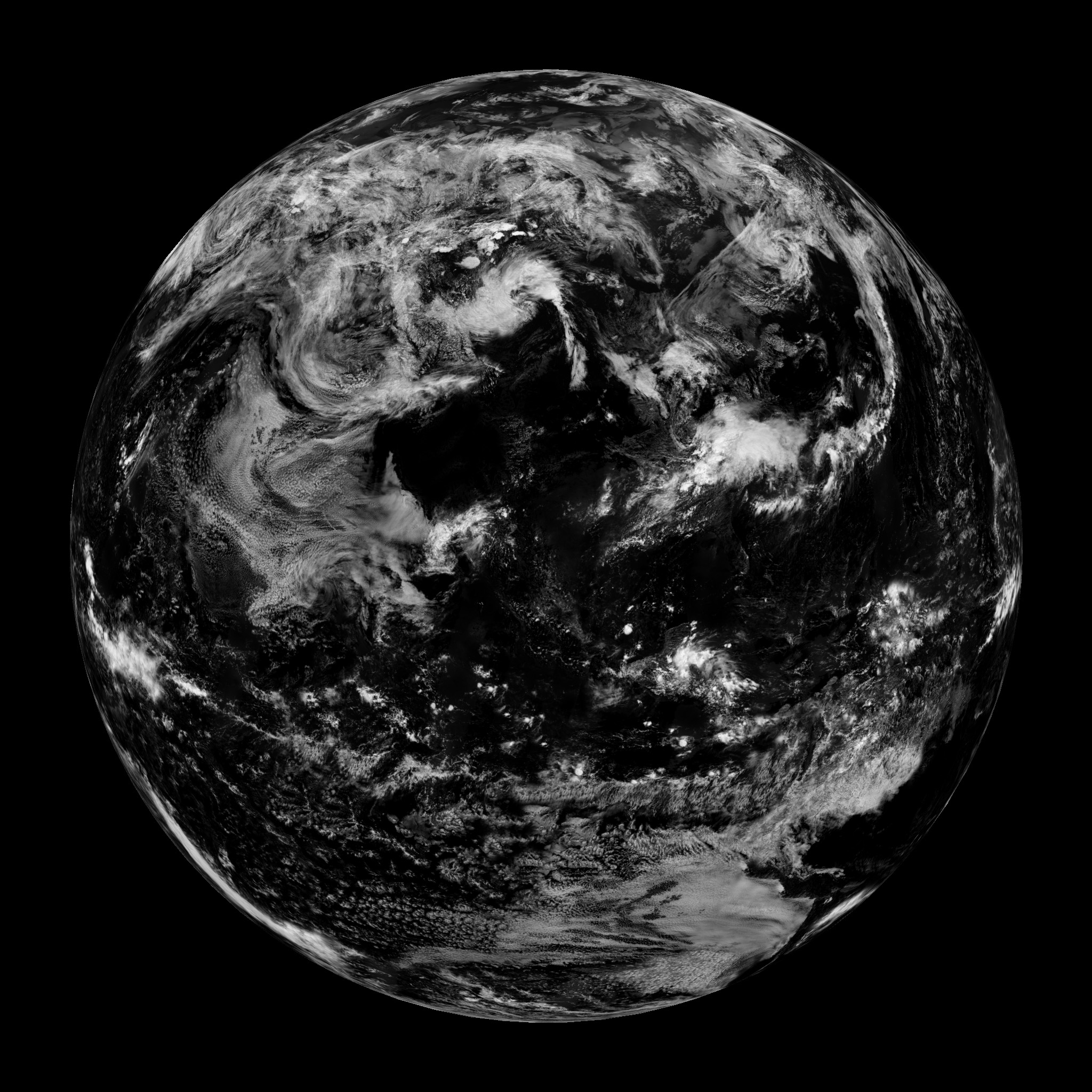

Dans cette partie, nous prendrons comme exemple l’instrument EPIC 5 (“Earth Polychromatic Imaging Camera” soit “Caméra d’imagerie polychromatique de la Terre” en français) situé à bord du satellite DSCOVR 6 (“Deep Space Climate Observatory” soit “Observatoire du climat dans l’espace lointain” en français).

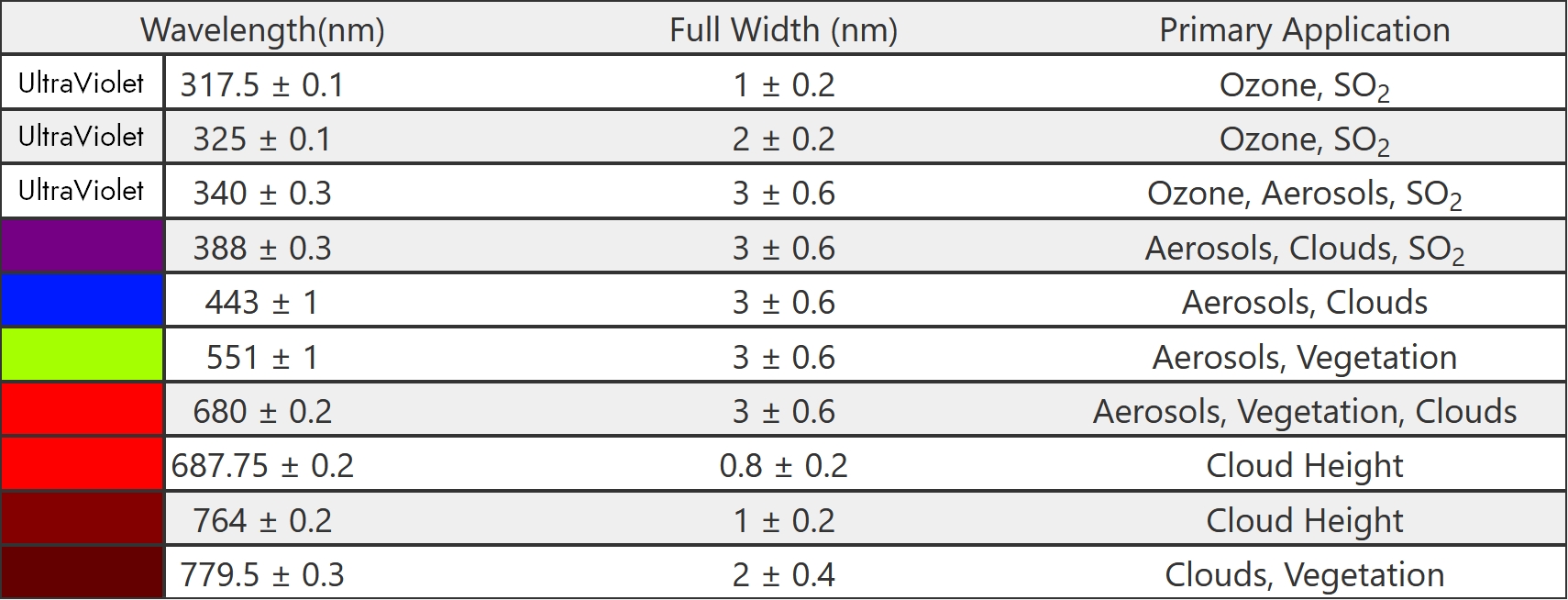

Voici les différentes longueurs d’onde photographiées par EPIC et les couleurs associées :

Comme indiqué sur le tableau ci-dessus, les différentes longueurs d’onde servent à étudier différents aspects de la Terre et de la composition de son atmosphère : l’ozone, les aérosols, les nuages et leur hauteur dans le ciel, la végétation et le SO₂ (dioxyde de souffre) dans le cas de DSCOVR.

C’est en assemblant les 3 longueurs d’onde des couleurs primaires du modèle RVB, c’est-à-dire le Rouge, le Vert et le Bleu (443, 551 et 680nm) que l’on obtient une photo en couleur naturelle.

La vidéo ci dessous montre comment on peut stacker (empiler) les images des trois longueurs d’onde RVB afin d’obtenir une photo en couleur naturelle.

Je vais apporter quelques précisions sur la vidéo, certaines choses étant contre-intuitive :

- Les palettes correspondent à différentes manière de visualiser les images et en aucun cas ce qui va réellement être empilé pour obtenir la photo finale en couleur naturelle.

- Les données brutes de chaque longueur d’onde sont difficilement visualisable telles qu’elles vont être empilées. En effet, le fichier h5 ne contient pas d’image a proprement parlé mais des informations brutes concernant chaque pixels de l’image. Pour chaque pixels, il est inscrit l’information d’intensité lumineuse pour la longueur d’onde concernée; par exemple, pour la longueur d’onde bleue, il va être indiqué pour chaque pixel l’intensité lumineuse correspondant au bleu, même chose pour le rouge et le vert. Lorsqu’on empile les images, on va donc créer un “nouveau” pixel combinant les informations d’intensité lumineuse de chaque longueur d’onde, ça reviens à dire “pour ce pixel, il y a telle quantité de bleue, telle quantité de vert et telle quantité de rouge”

Assemblage, déformation de photos et utilisation de calques afin de construire une photo de planète

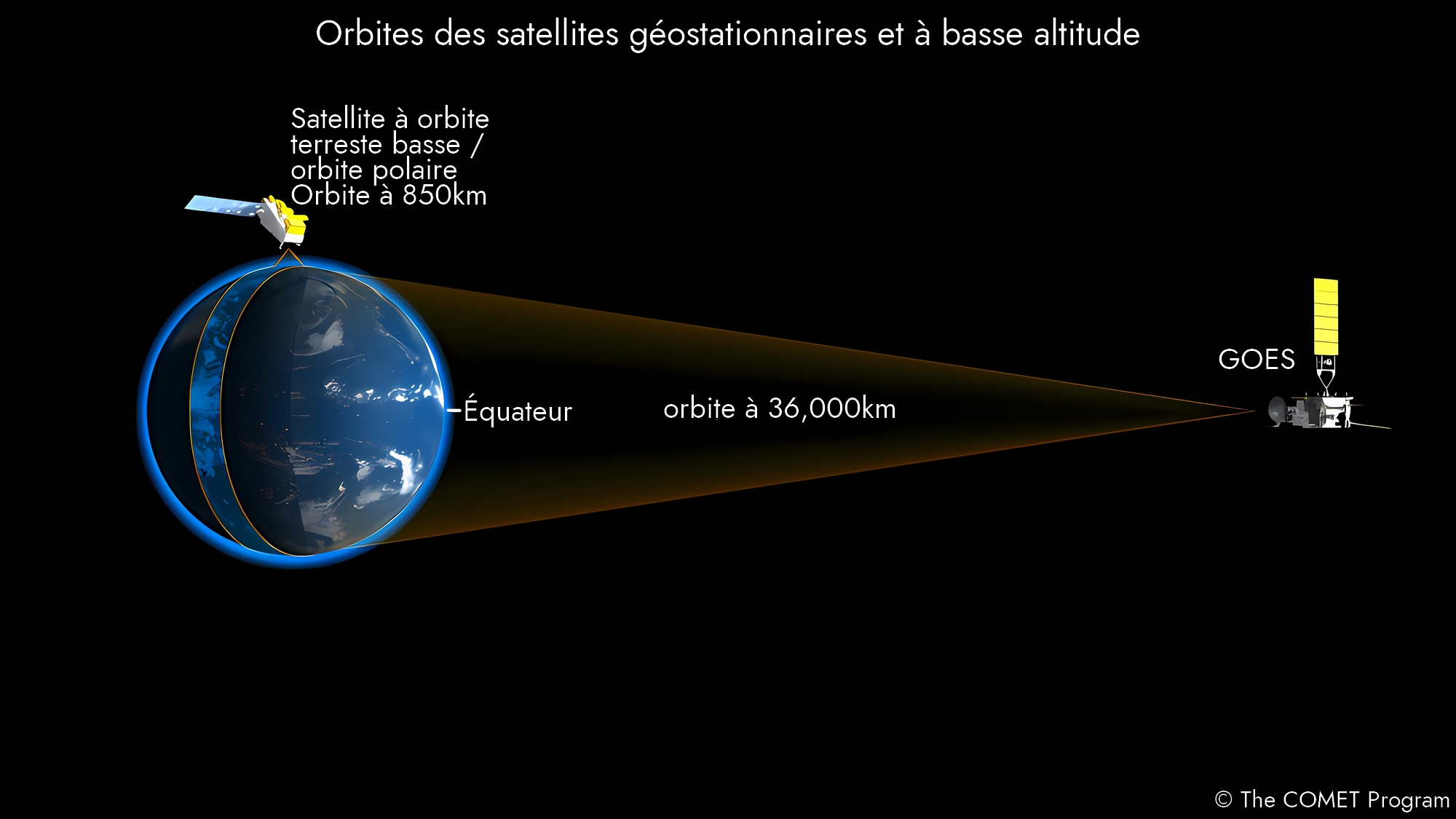

Nous allons maintenant aborder la partie la plus intéressante, mais aussi la plus technique : la construction d’une photo de la Terre à partir de photos prises avec des satellites en orbite basse. Il existe deux grandes familles de satellites permettant de photographier la Terre : les satellites météorologiques et les satellites d’observation de la Terre, ils sont situés soit en orbite basse (en moyenne entre 700 et 900 km d’altitude pour les satellites qui nous concerne dans cet article 6, mais l’orbite basse terrestre s’étend jusqu’à 2000 km d’altitude 7) soit en orbite géostationnaire située à 35.786 km d’altitude. Les satellites en orbite basse ne sont pas capables de photographier la Terre dans son intégralité, c’est pourquoi il est nécessaire d’assembler les photos.

Crédit : The COMET Program

Dans cette partie, nous allons prendre comme exemple l’instrument d’imagerie MODIS 8 qui est embarqué dans les satellites Terra et Aqua 9 10 de la NASA. Voici à quoi ressemble l’orbite de ces satellites et la couverture de l’instrument d’imagerie (sur l’animation, il s’agit en réalité du satellite PACE, car je n’ai pas trouvé d’animation en assez bonne résolution pour Terra et Aqua, mais ça ressemble à ça)

Crédits : NASA’s Scientific Visualization Studio 11

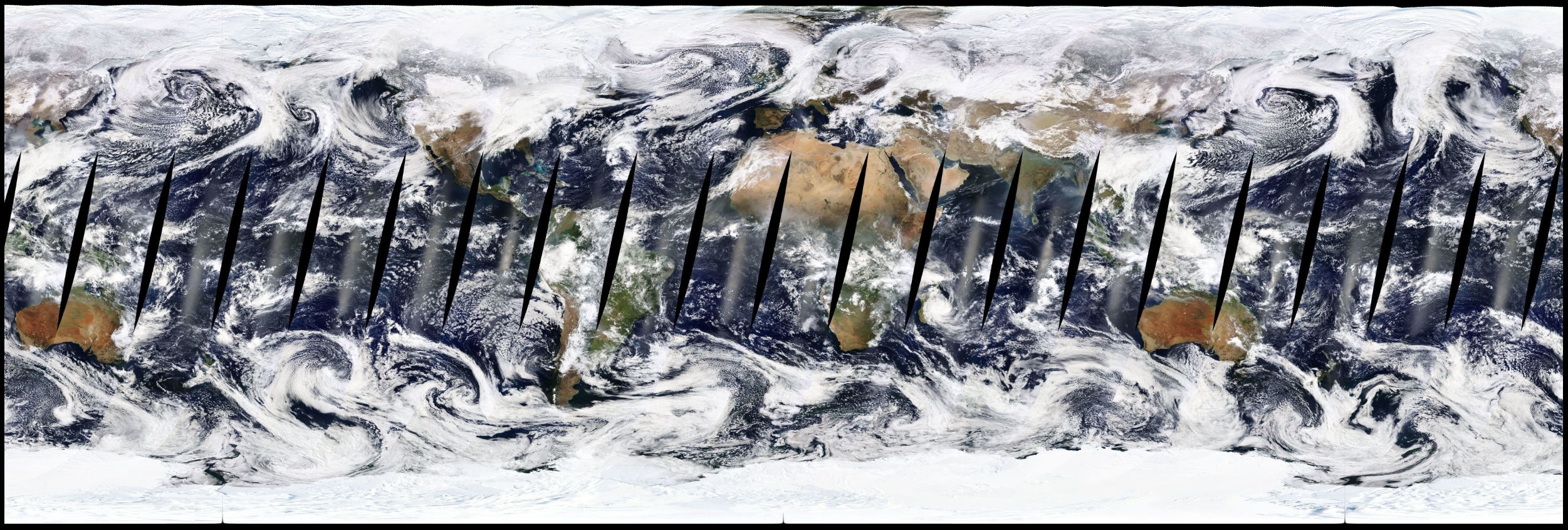

Avec cette orbite et cette couverture, voici le résultat obtenu par le satellite Aqua le 22 février 2022 :

Crédits : NASA / NASA Worldview 12

Et le résultat obtenu par le satellite Terra le même jour :

Crédits : NASA / NASA Worldview 12

En superposant les deux, on parvient à combler une partie les trous :

Crédits : NASA / NASA’s Goddard Space Flight Center 13

En récoltant suffisamment de photos et de données sur plusieurs périodes, il est possible de créer des calques des océans, de la surface terrestre et des nuages et de les assembler :

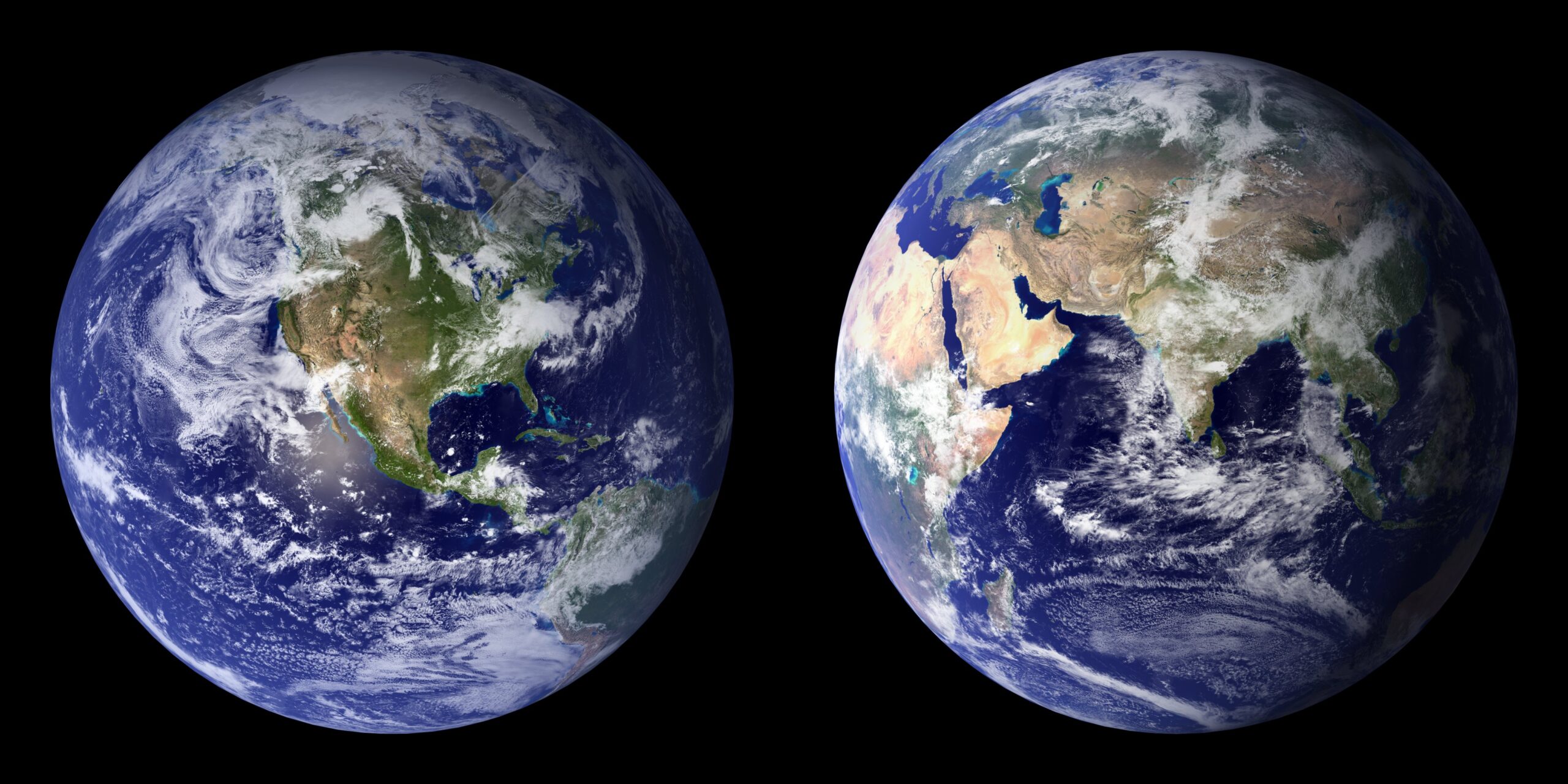

Crédits : NASA Goddard Space Flight Center Image by Reto Stöckli (land surface, shallow water, clouds). Enhancements by Robert Simmon (ocean color, compositing, 3D globes, animation). Data and technical support: MODIS Land Group; MODIS Science Data Support Team; MODIS Atmosphere Group; MODIS Ocean Group Additional data: USGS EROS Data Center (topography); USGS Terrestrial Remote Sensing Flagstaff Field Center (Antarctica); Defense Meteorological Satellite Program (city lights).

Les deux photos Blue Marble 14 ci-dessus n’ont pas été construites à partir des données présentées plus haut, mais à plusieurs autres dates : Les données de la surface terrestre ont été acquises de juin à septembre 2001. Les données sur les nuages ont été acquises en deux jours distincts : le 29 juillet 2001 pour l’hémisphère nord et le 16 novembre 2001 pour l’hémisphère sud. 15

En effet, comme expliqué précédemment, dans une photo composite, il est très fréquent que plusieurs jeux de données de plusieurs jours soient utilisés. Les instruments embarqués dans les satellites étant capables d’obtenir des images dans de très nombreuses longueurs d’ondes, il est possible de mettre en lumière et d’isoler certains éléments (océans, nuages, surface terrestre, etc).

Voici par exemple un masque qui a été créé pour visualiser la couverture nuageuse et détecter les endroits où le ciel est totalement dégagé : plus la couleur tend vers le rouge, plus le ciel est dégagé. Je l’ai superposé aux données photos de Terra pour que vous puissiez mieux comprendre :

NASA / NASA Worldview 12

C’est par cette technique que la photo composite du globe présente plus haute a été construite : principalement à l’aide de ces deux différents calques de la planète sans nuages et des nuages seuls :

Crédits : NASA Goddard Space Flight Center

Image par Reto Stöckli (surface terrestre, eaux peu profondes, nuages). Améliorations par Robert Simmon (couleur de l’océan, compositing, globes 3D, animation). 16 17

Les complotistes et les photos composites, une longue histoire…

Les complotistes adorent utiliser l’argument de la photo composite pour dire qu’il n’existe pas de vraies photos de la Terre dans son entièreté et qu’elles sont toutes générées par ordinateur. S’il est vrai que les satellites fournissent des photos composites, il est totalement faux de dire qu’elles sont fausses, en effet, c’est ignorer les faits suivants :

- Même si elles peuvent être construites par assemblages, déformations et utilisation de calques comme nous l’avons vu dans le chapitre précédent, elles le sont à partir de données et de photos satellites bien réelles.

- Les photos composites construites à partir des trois longueurs d’onde RVB utilisent simplement 3 vraies photos dans 3 couleurs différentes, ça reviendrais un peu à dire que les photos de votre smartphone ou votre appareil photo reflex sont fausses car leurs capteurs CMOS 18 ou CCD 19 traitent la lumière qu’ils reçoivent à l’aide de photosites 20 et d’une matrice de filtres colorés 21 ne laissant passer que le rouge, le vert ou le bleu.

Les photos prisent par DSCOVR ne peuvent donc pas être considérées comme composite au sens ou l’entendent les complotistes.

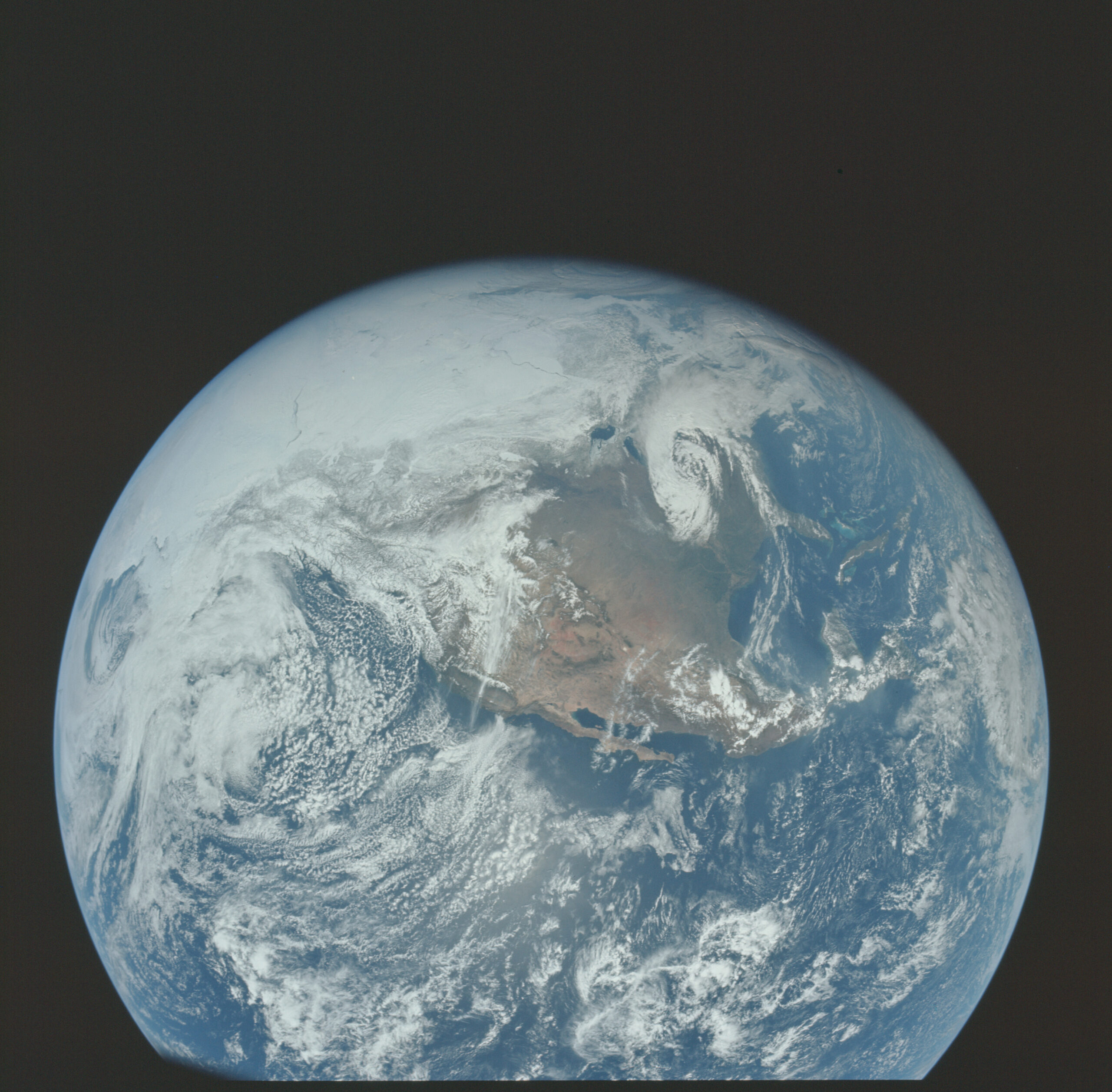

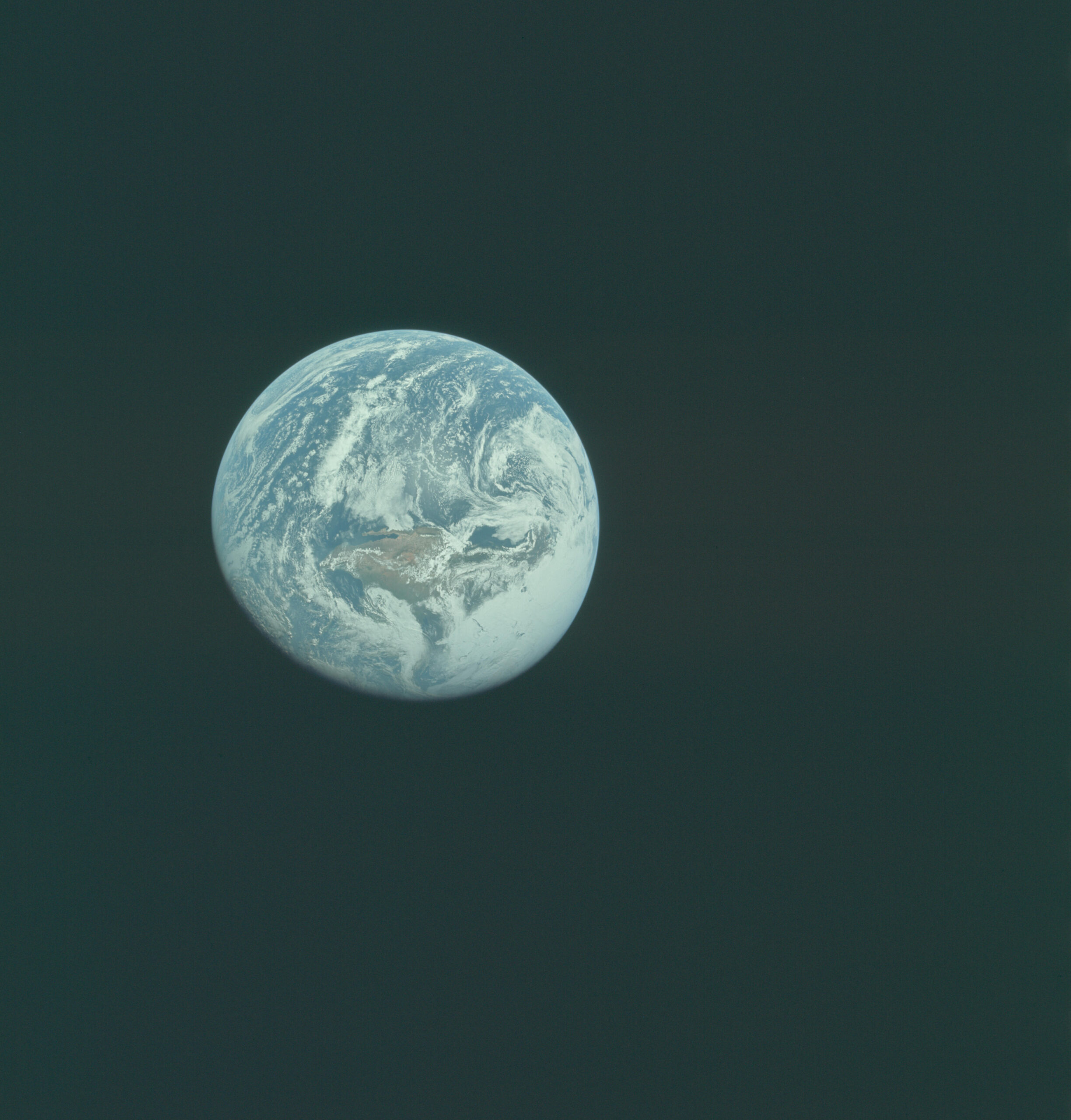

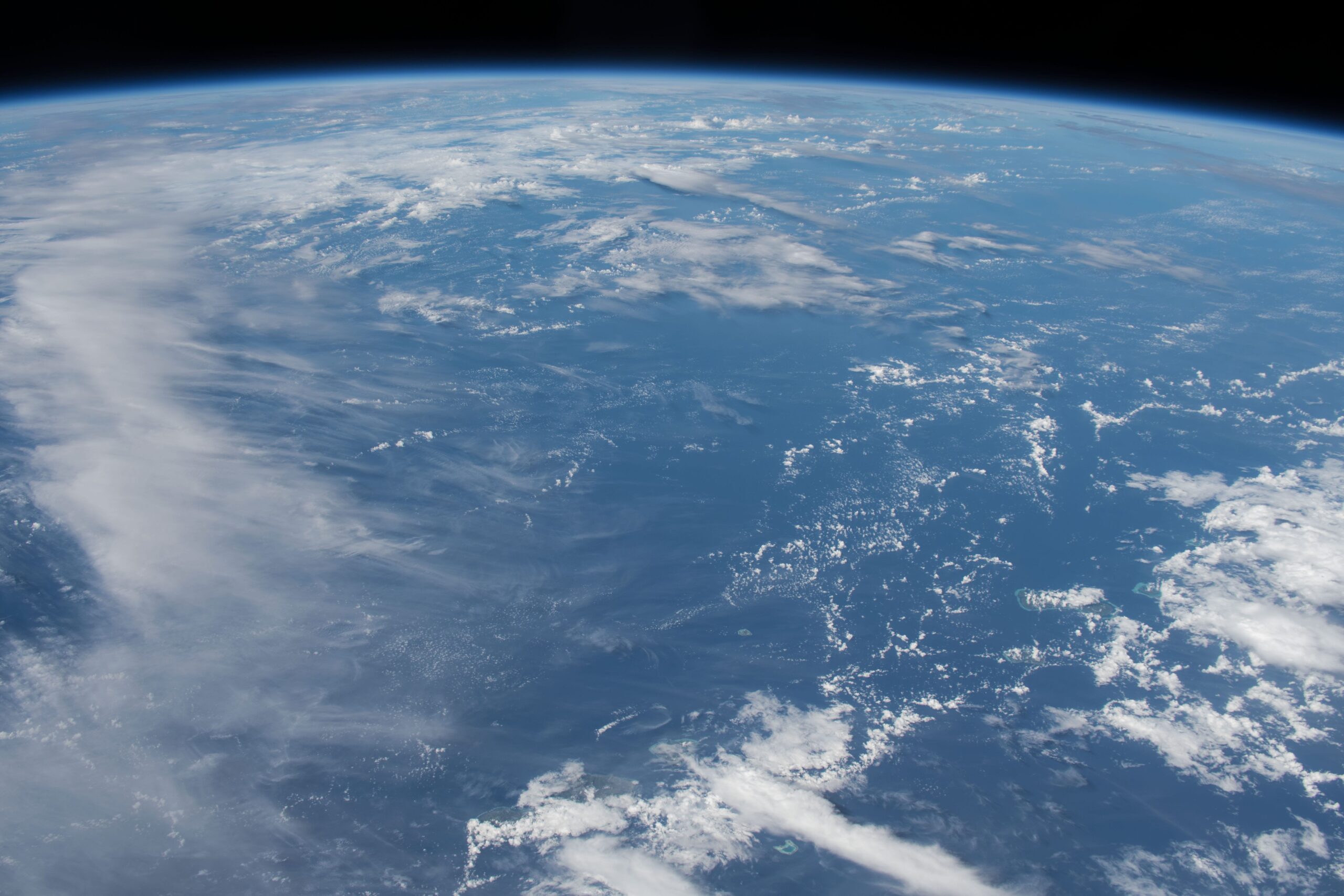

De plus, il existe tout de même des photos prises avec des appareils photo classiques, comme les photos de la Terre prises par les missions Apollo ou à bord de la Station Spatiale Internationale. Les photos prises depuis l’ISS ne montrent certes pas la Terre dans son ensemble dû à l’altitude relativement basse à laquelle elle se trouve, la courbure de la Terre est bien visible sur des dizaines voir centaines de milliers de clichés.

Voici une petite sélection de photos de la Terre prises lors des missions Apollo, avec un appareil argentique (c’est-à-dire avec une pellicule) de la marque Hasselblad :

Crédit : NASA

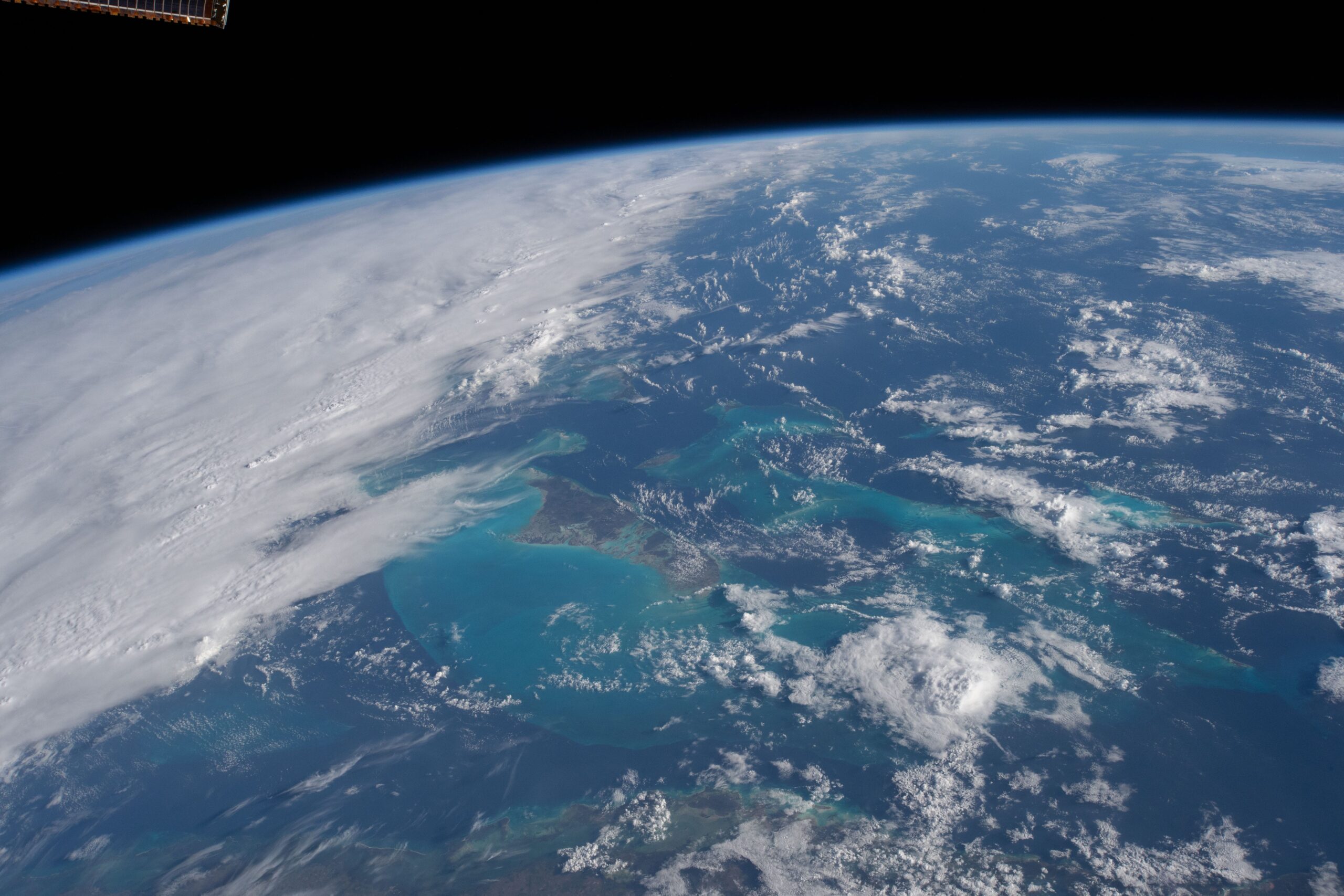

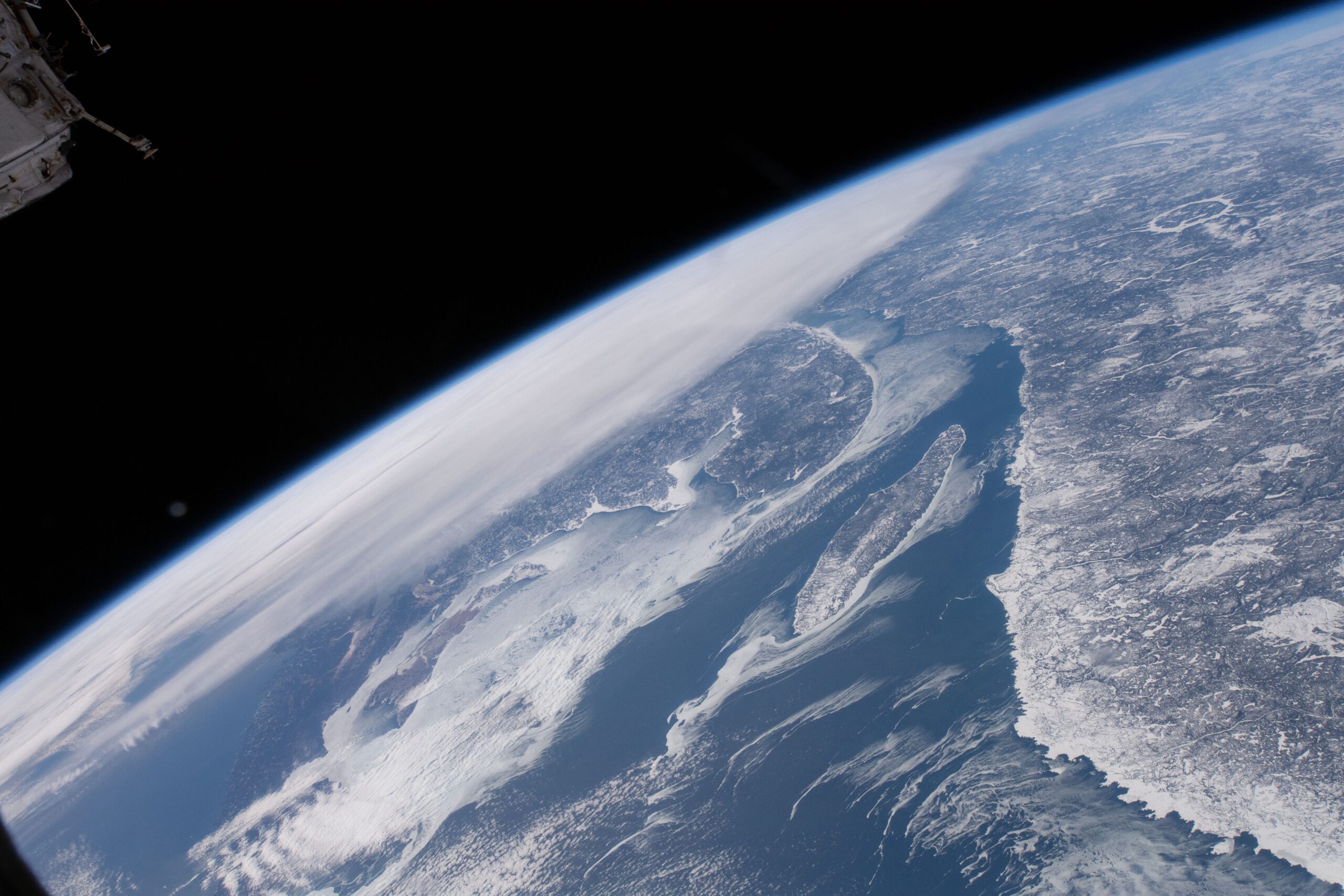

Et une sélection de photos prises lors de la mission 58 à bord de l’ISS :

Crédits : Oleg Kononenko – RSA / David Saint-Jacques – ASC / Anne McClain – NASA

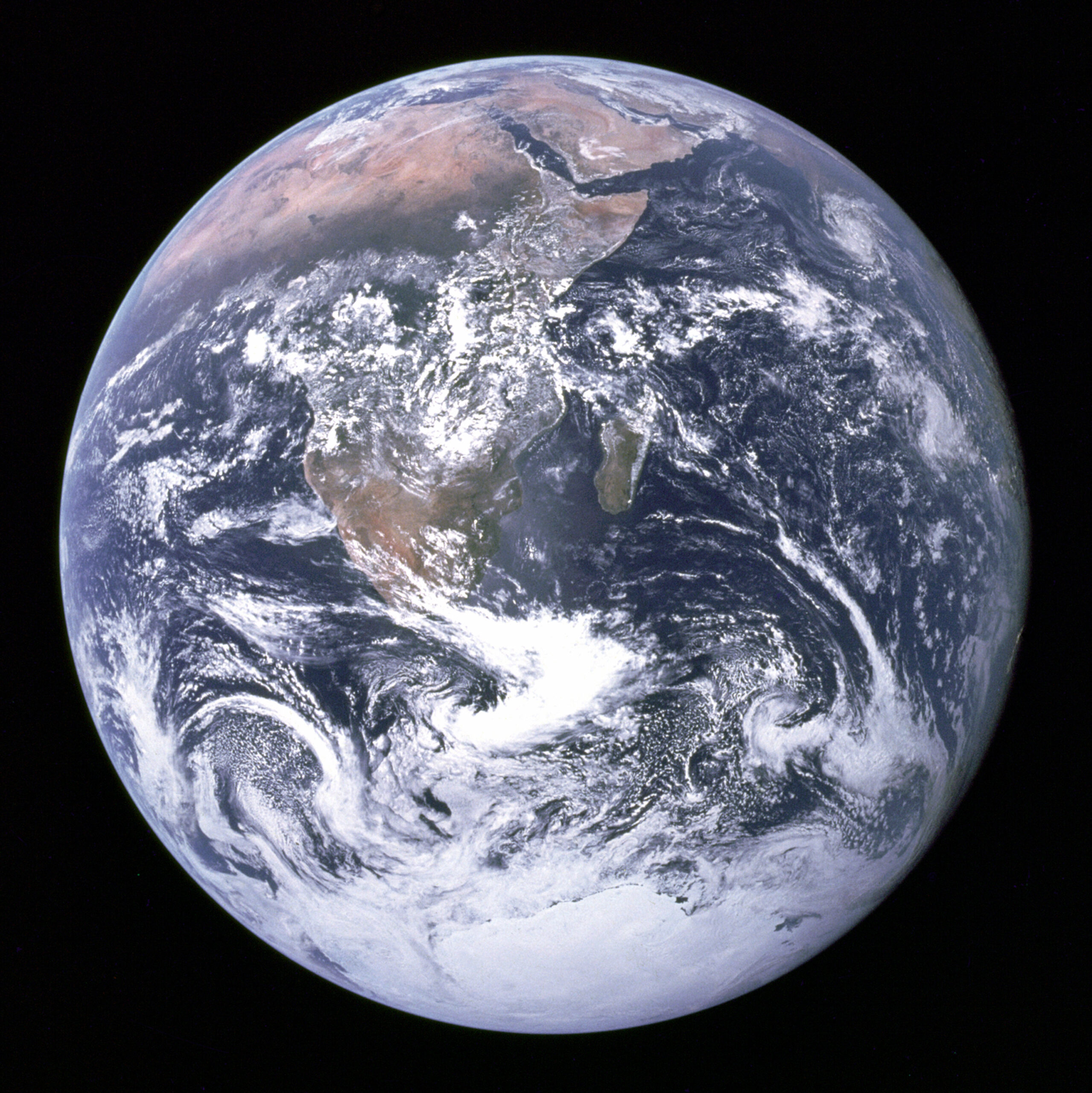

Pour terminer ce chapitre et cet article, nous allons brièvement aborder les photos que l’on appelle “Blue Marble”. Il s’agit de différentes photos de la Terre dans son intégralité, souvent utilisées par les complotistes.

La première “Blue Marble” a été prise par l’équipage d’Apollo 17 le 7 décembre 1972. C’est la première photo de la Terre qui la montre entièrement éclairée, même si les missions Apollo précédentes avaient déjà réussies à la photographier quasiment entièrement éclairée. La photo en question est celle-ci :

Crédits : NASA / équipage Apollo 17

Par la suite, différentes versions de la Blue Marble ont été ajoutées, notamment celle dont nous avons parlé dans le chapitre 1.3 construite par Robert Simmon à l’aide des photos du satellite Terra qui est, elle, une photo composite. Nous pouvons également parler de celle de 2012, construite à l’aide des données du satellite Suomi NPP. C’est elle aussi une photo composite.

Crédits : NASA / NOAA / GSFC / Suomi NPP / VIIRS /Norman Kuring

Voici une autre “Blue Marble” prise par le satellite DSCOVR 50 ans après la première d’Apollo 17. Bien que composite également, la Terre a été prise dans son intégralité sans autre manipulation que la superposition des trois photos prises dans les longueurs d’onde rouge, verte et bleue :

Crédits : NASA / NASA EPIC Team

Voila, cet article est terminé, j’espère qu’il vous aura fait rêvé et que les photos composites n’ont plus de secrets pour vous à présent.

Si cela vous intéresse, j’ai également rédigé un article concernant les photos en fausses couleurs :

Sources & Crédits

- Panorama de Mars : https://photojournal.jpl.nasa.gov/catalog/PIA23623

- Panorama de la Lune : https://www.lpi.usra.edu/resources/apollopanoramas/pans/?pan=JSC2004e52772

- Apollo Lunar Surface Experiments Package : https://fr.wikipedia.org/wiki/Apollo_Lunar_Surface_Experiments_Package

- Générateur thermoélectrique à radioisotope : https://fr.wikipedia.org/wiki/G%C3%A9n%C3%A9rateur_thermo%C3%A9lectrique_%C3%A0_radioisotope_multi-mission

- EPIC : https://epic.gsfc.nasa.gov/about/epic

- DSCOVR : https://www.nesdis.noaa.gov/current-satellite-missions/currently-flying/dscovr-deep-space-climate-observatory

- Orbite basse terrestre : https://fr.wikipedia.org/wiki/Orbite_terrestre_basse

- Liste des satellites artificiels et leur orbite : https://space.oscar.wmo.int/satellites

- MODIS : https://fr.wikipedia.org/wiki/Moderate-Resolution_Imaging_Spectroradiometer

- Terra : https://fr.wikipedia.org/wiki/Terra_(satellite)

- Aqua : https://fr.wikipedia.org/wiki/Aqua_(satellite)

- Orbite et couverture de PACE : https://svs.gsfc.nasa.gov/5185/

- NASA Worldview : https://worldview.earthdata.nasa.gov/

- Combinaison des photos de Terra et Aqua : https://svs.gsfc.nasa.gov/31223/

- Blue Marble : https://fr.wikipedia.org/wiki/La_Bille_bleue

- Blue Marble 2001/2002 : https://visibleearth.nasa.gov/images/57723/the-blue-marble

- Comment une photo composite “Blue Marble” est-elle créée ? : https://earthobservatory.nasa.gov/blogs/elegantfigures/2011/10/06/crafting-the-blue-marble/

- Capteur CMOS : https://fr.wikipedia.org/wiki/Capteur_%C3%A0_pixels_actifs

- Capteur CCD : https://fr.wikipedia.org/wiki/Capteur_photographique_CCD

- Photosites : https://www.maxicours.com/se/cours/le-capteur-les-photosites-et-le-passage-aux-pixels/

- Matrice de filtres colorés : https://fr.wikipedia.org/wiki/Matrice_de_filtres_color%C3%A9s

Comments are closed.